Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

Tags

- Selenium

- 한빛아카데미

- 비지도학습

- 생활코딩

- 논문리뷰

- jupyter

- aws

- 딥러닝

- MySQL

- 셀레니움

- Lamp

- 프로그램새내기를위한자바언어프로그래밍

- AndroidStudio를활용한안드로이드프로그래밍

- 한빛미디어

- 밑바닥부터시작하는딥러닝2

- 수동설치

- 컴파일설치

- 예제중심HTML&자바스크립트&CSS

- 머신러닝

- deeplearning

- image

- word2vec

- attention

- 크롤링

- Apache

- 소스설치

- CBOW

- Crawling

- 가비아

- 밑바닥부터시작하는딥러닝

Archives

- Today

- Total

안녕, 세상!

UW-NET : An Inception-Attention Network For Underwater Image Classification 본문

It공부/딥러닝논문리뷰

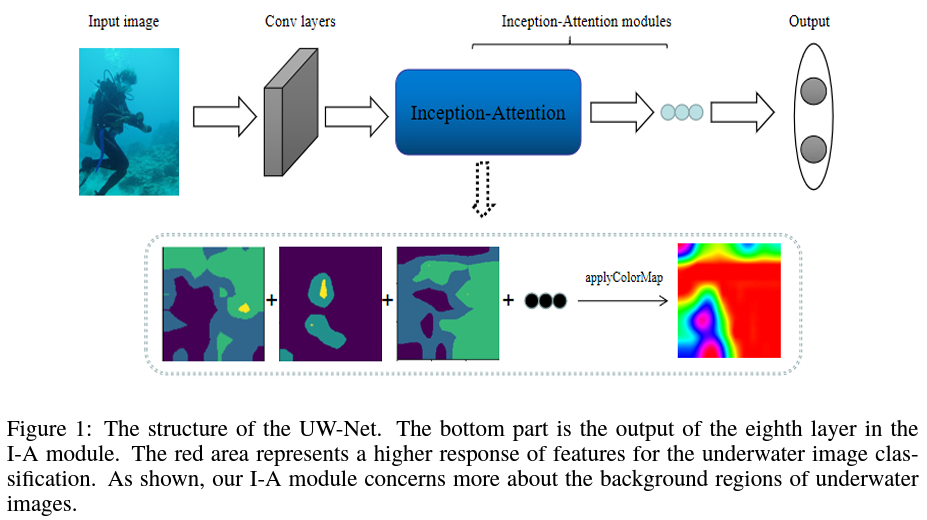

UW-NET : An Inception-Attention Network For Underwater Image Classification

dev_Lumin 2022. 2. 15. 22:20Abstract

- For underwater image classification

- Simulate the visual correlation of background attention with image understanding for special environments, such as fog and underwater by I-A module

- I-A moudule : Inception-Attention module

Introduction

- Underwater image : Complex distortions (low contrast, blurring, non-uniform brightness...)

- Three key points

- 1) 서로 다른 환경들에서 찍힌 underwater images의 background는 다양함

- 2) Salient objects는 underwater환경뿐만 아니라, air환경에도 존재하고,

salient objects로부터 추출된 features는 underwater images의 분류를 해결하는데 주로 의지하여 사용될 수 없음- Salient objects ( e.g. ruins, fish, diver)

- 3) Underwater classification은 dualistic classification task이기 때문에, 제안된 구조는 over-fitting을 피하기 위해서 simple해야함

Problems

- Dataset이 부족할 때, CNN의 depth와 width를 증가시키면 over-fitting이 더 쉽게 발생할 수 있음

Solutions

- 위의 문제를 해결하기 위해, 다음을 사용

- Multi-scale convolution and pooling on a level of CNN

- To output multi-scale features

- Attention mechansim

- Multi-scale convolution and pooling on a level of CNN

- 사람들이 Underwater images를 이해할 때, Background area와 같은 large-scale features가 visual attention mechanism에서 중요한 역할을 한다는것을 찾음

- Natural scene image classifcation에서 적용된 attention mechanism과는 달리

- UW-Net은 I-A modules를 구축함으로써, images의 background features에 더 attention함

그럼으로써 더 나은 성능을 성취함

Proposed Approach

STEM

- First forwared to a convolution layer with 7x7 size of kernels

- → To obtain large reception fields

3.1 Inception-Attention Module

- Classical inception models : constructed by multiple sizes of convolution kernels

- 하지만 모든 convolutino kernel의 추출된 features가 current image classification task에 긍정적으로 연관되는것은 아님

- 예를들어, kernel with large size는 global information을 묘사하는 경향이 있지만, 세밀한 image classification에 거의 영향이 없을것임

3.1.1 Inception Module

- Underwater images

- Recognition of underwater image is based more on the global features of the image

- Poor quality due to the effects of lighting absorption and scattering

- 위의 특징을 기반으로,

- Convolution kernel with large size

- Average pooling

- → To reduce the impact of local features of the image on the final classification*

- Convolution kernel sizes in the inception module which are used in the experiments

- 1x1

- 5x5

- 7x7

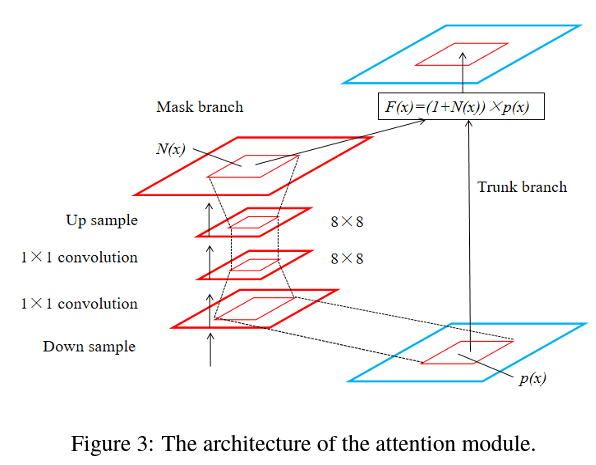

3.1.2 Attention Module

- Soft attention을 기반으로 attention module을 구축함

- 인간의 underwater image의 인식을 구현하기하는 trunk branch와 mask branch로 구성되어 있음

- Trunk branch

- Inspired by residual network

- Output the previous layer as input directly

- → So that the basic features of the image can be transmitted to the deep layers of network*

- Mask branch

- Donwsampling → Upsampling

- Activation function for first and second convolution layers are Relu and sigmoid

- $F(x)$ : Final output

- $N(x)$ : The adaptive weight for a point $x$

- $P(x)$ : Original feature map, in the range of [0,1]

3.2 Auxiliary classification branch and loss function

- Output of the second I-A module

- → To reudce the risk of over-fitting

- Auxiliary classifier이 convergence를 가속할 뿐만아니라, test set에 대한 accuracy도 향상시킴

Loss function

- $J$ : Loss function

- $J_0$ : Cross entropy of the final output of the model and the real label of the image

- $J_1$ : Cross entropy of the output of the model’s auxiliary classification branch and actual label

- $\alpha$ : Weight attenuation coefficient of the network

- $L$ : $L2$ regularization term (weight)

3.3 The UW-Net Network

- Table 1 기반 설계됨

- 첫 번 째 I-A module에 들어가기전에 image의 size는 36x36으로 줄어듬

- 두 convolution과 one pooling 함수에 의해서 input image channel은 32로 증가됨

- Final prediction of model은 Avgpool과 FC layer을 거친 후에 얻어짐

Experiments

4.1 Benchmark dataset

- Underwater images의 다양성을 보장하기 위해 ImageNet dataset, JAMSTEC dataset 그리고 online underwater images로부터 4000개 넘는 underwater images를 수집함

- Non-underwater images를 5000개 넘게 ImageNet으로부터 수집하여, non-underwater images라고 라벨링함

4.2 Training and Analysis

- Training : Testing = 70% : 30%

- Augment the data by rnadom clipping and flipping

- → to reduce the risk of over-fitting

- Initialization method proposed by He et al. (2015)

- SGD with mini-batch size of 32

- The weight decay rate : 0.001

- Momentum rate : 0.9

- Initial learning rate : 0.001

- The learning rate is decreaed ten times of its original value at 1k and 2k iterations

- The training end at 3k interations

- The loss curve

4.3 Experimental results

- 다른 모델과 비교

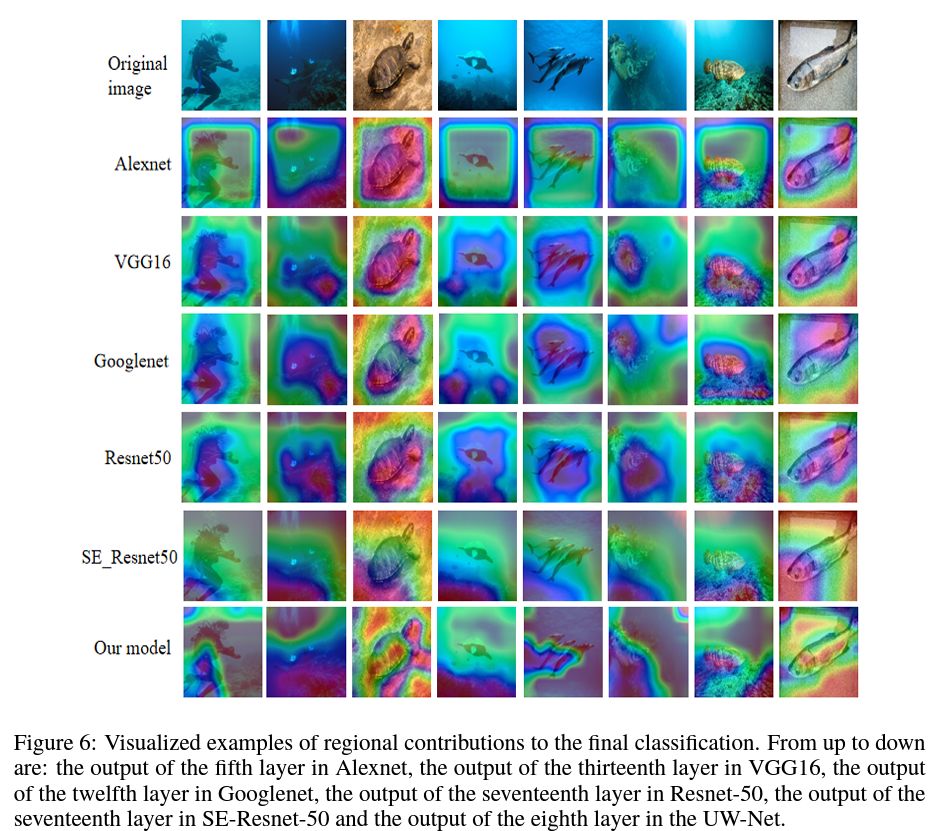

- Class activation maps (CAMs)

- 더 어두은 붉은 색은 final classification에서 영역의 중요성을 더욱 나타내는것임

- UW-NET이 다른 모델들 보다 background에 더 집중함

- Table2 를 보면 성능이 좋은것을 확인가능

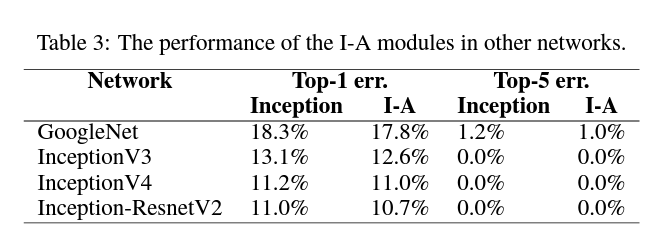

4.4 The Performance of the I-A Module

- I-A module은 다른 image classification networks에 사용 가능

- I-A의 일반적 능력을 증명하기 위해, Down sampling 시 maxpooling을 사용하는 제안한 I-A module을 다른 모델들에 embed시킴

- ILSVRC-2012 dataset : 100 categories

- Error rate가 줄어든것을 확인 가능

정리

- Background의 특징을 잡아내기 위해 비교적 큰 convolutional kerenl을 Inception branch부분에서 사용했으며, Attention을 사용함

- Over-fitting을 줄이고자 Auxiliary classification branch 추가

'It공부 > 딥러닝논문리뷰' 카테고리의 다른 글

Comments