Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

Tags

- 수동설치

- Apache

- deeplearning

- MySQL

- 한빛아카데미

- 가비아

- 컴파일설치

- 셀레니움

- 예제중심HTML&자바스크립트&CSS

- 딥러닝

- aws

- 소스설치

- 크롤링

- Crawling

- CBOW

- Selenium

- 밑바닥부터시작하는딥러닝

- 생활코딩

- jupyter

- 한빛미디어

- 프로그램새내기를위한자바언어프로그래밍

- 비지도학습

- 논문리뷰

- attention

- 밑바닥부터시작하는딥러닝2

- image

- AndroidStudio를활용한안드로이드프로그래밍

- 머신러닝

- Lamp

- word2vec

Archives

- Today

- Total

안녕, 세상!

Multimodal Emotion Recognition With High-Level Speech And Text Features 논문 본문

It공부/딥러닝논문리뷰

Multimodal Emotion Recognition With High-Level Speech And Text Features 논문

dev_Lumin 2022. 1. 8. 21:07Abstract

- 최신 연구들은 emotion recognition task를 해결하기 위해 low-level data representations로 deep learning models를 학습함

- emotion datasets가 빈번히 data양에 한계를 가지고 이러한 접근들은 overfitting으로 고통받을 수 있으며, 깊이 없는 단서들 기반으로 학습될 것임

- 이러한 문제를 해결하기 위해서,

disentanglement representation learning으로 부터 영감을 받은

새로운 cross-representation speech 모델을 제안함- wav2vec 2.0 speech features로 emotion recognition을 수행함

- Transformer-based models에서 추출된 text feature로 부터 감정을 인식하기위한 CNN-based model을 학습시킴

- 더 나아가 speech-based와 text-based 결과를 score fusion 접근 방식을 가지고 합침

- IEMOCAP dataset 의 4-class classfication 문제로 평가됨

- speech-only, text-only, multimodal emotion recogntion의 분야에서 최신 연구 성능을 초월함

1. Introduction

- 많은 연구들이 emotion recognition 방식을 준언어(비언어적) features 혹은 수정된(transcribed) text data로 부터 제안함

- 하지만 준언어에 반영한다면 언어적 소통 의미는 바뀔것이고 반대도 마찬가지임

- 그러므로 spoken text는 speech 억양에 따라 다르게 해석될 것임

- emotion recognition에서 가장 근본적 도전과제 중 하나는 data안에서 emotion 단서들을 잡아내는것

- 대부분 최신 연구들이 데이터로부터 이러한 feature sets를 추출하기 위해 deep learning training을 제안했고,

만족스러운 결과를 야기했지만 두 가지 문제들이 존재함- 이러한 모델들이 주로 low-level data representations을 사용하여 밑바닥부터 학습되기 때문에 overfitting을 쉽게 초래할 수 있음

- deep learning 구조들은 얕은 단서들로 부터 학습된다고 알려져있는데 여기서 최신 모델들이 정말로 데이터로부터 emotion 정보를 잡아내는지 아닌지에 대한 의문점

- 위의 문제들을 다루기 위해

- speech-based와 text-based emotion recognition 연구들에서 흔하게 사용되는 low-level data representations에 도전하고(이의를 제기하고),

- 논문의 방식에 high-level-features를 포함함으로써 해결하고자 함

- low-level : feature engineering에서 얻은 features

- high-level : deep learning 접근으로부터 추출된 generic features

- speech emotion recognition을 위한

cross-representation model을 제안함- high-level wav2vec 2.0 것들로 부터 low-level mel-spectrogram speech representations를 재구성하는데 목표를 잡기 위함임

- → 두 표현들 모두 활용하게 됨

- wav2vec를 선택한 이유는 풍부한 운율적 정보를 포함하기 때문

- speech로 부터 포괄적인 감정 표현을 잡아내기 위해 disentanglement representations learning 기술들을 데이터 안 speaker의 identity와 음성 변이(phonentic variations)를 제거하는데 사용

- Transformer-based models에서 추출된 text feature로 부터 감정을 인식하기위한 CNN-based model을 학습시킴

- Transformed-based models에서 얻은 features들이 흔하게 사용되는 word2vec과 GloVe features보다 더 낫다고 판단

- 판단 이유는 문장에서 긴 문맥적 정보를 modelling하는 Transformer의 능력 때문

- 최종적으로 multimodal emotion recognition 결과를 얻기 위해 speech-based와 text-based 결과를 합침

2. Related Works

2.1 Wav2vec 2.0

- self-supervision을 통한 speech representations를 얻기위한 framework

- wav2vec model은 많은 양의 unlabelled speech data로 학습되고 나서 ASR를 위한 labelled data로 fine-tuned됨

- Wav2vec은 feature encoder과 context network로 구성됨

- Encoder

- input으로 raw waveform을 받음

- 20ms의 stride와 25ms의 receptive field를 이용하여 features의 sequence를 ouputs로 출력함

- Encoder

receptive field : 수용영역

수용영역이란 외부 자극이 전체 영향을 끼치는 것이 아니라 특정 영역에만 영향을 준다는 뜻

convolution filter 부분과 같은듯- 이러한 features는 speech의 위치 정보를 encode하고 wav2vec의 ‘base’와 ‘large’ 버전에 대해 각각 768과 1024의 크기를 가짐

- 이 후 feature sequence는 Transformed-based context network로 입력됨

- ‘base’ wav2vec : 12 Transformer blocks

- ‘large’ wave2vec : 24 Transformer blocks

- Transformed-based context network는 speech의 contextualized representation을 출력함

- wav2vec 2.0이 원래 ASR에 적용하기위해 학습된 representations임에도 불구하고,

speech emotion recognition과 같은 다른 과제에서도 이 representations로 부터 이득을 볼 수 있음(유용하게 사용될 수 있다는 뜻)

2.2 Speech Emotion

- SER(Speech emotion Recognitino) 문제 특성은 speech로부터 emotion을 나타내는 적절한 특징을 정의하는것

- 이전 연구들에서는 emotion 정보를 MFCC, pitch 그리고 energy로 부터 추출해서 찾으려고 함

- 최신 연구에서는 pre-trained된 wav2vec 2.0 model에서의 local과 상황별(contextualized) outputs를 합치는 학습 가능한 가중치들을 이용하여 가중합을 이용하는것이 더 나은 SER 결과를 나타낸다고 보여짐

2.3 Text Emotion Recognition

- 최신 TER(Text Emotion Recognition) 연구에서는 밑바닥부터 학습된 ASR model의 features를 사용하거나 혹은 Word2Vec 혹은 GloVe features를 사용함

- 위의 방식도 좋은 결과를 나타내지만, NLP 과제에서 Transformers 기반 모델들이 월등한 성능을 보여주면서 기존 방식에 대한 의문을 가지는 것은 당연함

2.4 Disentanglement Representation Learning

- 해당 learning은 데이터안에서 근본적인 변화(variation) 요인들을 분리시키는것을 목표로 둠

- 이러한 요인들을 분리시킴으로써 해결하고 싶은 과제에 대해서 관련성이 있는 요인들을 유지하면서 유용하지 않는 요인들을 버릴 수 있음

- Disentanglement는 image, video, speech applications에서 적용되어 왔음

- speech 관련 연구에서는 주로 speech conversation과 prosody transfer 연구들에서 적용됨

- AutoVC

- speech conversation에서 speech content의 speaker-independent representation을 추출하는 autoencoder

- (speaker가 누구인지 신경쓰지 않고 추출한다는 것인듯)

- Mel-spectrogram은 모델의 encoder에 input으로 들어감

- decoder은 encoder의 ouputs로부터 spectrogram과 speaker identity embedding을 재구성(복원) 함

- encoder의 bottleneck size를 조절함으로써, speaker identity 정보는 encoder의 bottleneck에서 제거됨

- Speech-Flow는 AutoVC를 기반으로 speech를 pitch, rhythm 그리고 content featurs로 분리함

- 관련 다른 연구에서 i-vectors와 x-vectors로 부터 speech style과 speaker identity를 disentangle하기 위한 autoencoder을 제안했고 그들은 speech style embedding을 SER에 사용했음

- 또 다른 관련 연구에서는 adversarial training을 사용하여 speech features를 speaker identity와 emotion features로 분리함

- 이런 방식들은 논문에서 제안된 방식과 비슷한점이 있지만 차이점은 이전 연구들과 다르게 emotion features를 얻기 위해서 speaker identity 정보를 완벽하게 제거한다는 점과

experiments를 이러한 features의 disentanglement 속성에 대한 실험을 수행한다는 점임

3. Methodology

SER model

- input으로 wav2vec features와 melspectrogram, speaker identity embeddings 그리고 phone sequence로 받음

- 이 모든 features는 같은 speech segment로 부터 추출됨

- 모델은 speech segment에 대한 각 emotion class의 확률을 출력함

TER Model

- 말을 글로 옮긴 기록으로부터 추출된 text featurs를 input으로 받음

- 말에 대한 각 emotion class의 확률을 출력함

- SER과 TER 결과는 multimodal emotion class 확률을 얻기 위해 점수 융합을 통해 결합됨

- SER, TER model 그리고 fusion 접근에 대한 그림

3.1 Speech Emotion Recognition

- wav2vec 2.0 features를 input으로 받고 대응하는 melfrequency spectrogram을 재구축하는

encoder-decoder model을 제안함 - 모델은 4개의 주요 요소로 구성

- encoder

- decoder

- phone encoder

- classifier

- 모델은 약 2초 길이 정도되는 96frames의 speech segments으로 학습됨

- 이러한 segments는 training과정 동안 speech utterances로부터 무작위로 잘라짐

- 논문의 SER model은 AutoVC와 비슷함

- 하지만 세 가지 부분이 다름

- 1) wav2vec features는 모델의 encoder에 acoustic한 input을 넣게 됨 ( wav2vec input에 acoustic한것을 넣어서 그런듯)

- 2) emotion classfier와 해당 논문 방식의 emotion loss를 포함시킴

- 3) decoder에 입력이 될 outputs를 가진 phone encoder을 정의함

- 하지만 세 가지 부분이 다름

3.1.1 Wav2vec 2.0 Feature Extraction

- LibriVox dataset에 있는 60k hours의 unlabelled speech data로 pretrained된 “large” wav2vec 2.0 model로 부터 wav2vec features를 추출함

- feature encoder의 ouput과

context layers안에 있는 모든 24개의 Transformer layers의 ouput으로 부터

features을 얻음 - 그러므로 각 speech frame마다 1024-dimensional wav2vec features가 25개가 있음

3.1.2 Speaker Identity Feature Extraction

- LibriSpeech, VoxCeleb1 그리고 VoxCeleb2에서 pretrained 된 Resemblyzer을 사용하여 speaker identity features를 추출함

- 각 utterance(말) 마다 speaker identity를 표현하는데 256-dimensional embedding이 얻어짐

- 각 speaker(화자)마다 랜덤하게 선택된 100개 말들로부터 speaker identity features를 추출하고 그것들의 평균을 speaker을 표현하는 최종 identity embedding으로 사용

3.1.3 Encoder

- $h_{avg}$ : weighted average

- $\alpha$ : trainable weights

- $h_i$ : wav2vec 2.0 features ( 25개 )

- $h_{avg}$는 256-dimensional speaker identity embedding과 frame 대 frame 마다 concatenated됨

- encoder안의 BLSTM layers는 $d$ 뉴런들을 가지고 ouput은 $[2d, 96]$의 크기를 가짐

- layers의 ouput을 forward와 backward 방향들 모두로 concatenate했기 때문에 위와 같은 크기 가짐

- $d$는 bottleneck의 크기를 결정하고 channel dimension의 features의 크기가 감소시키는 역할을 함

- downsampler operation은 각 speech frame마다 $2d$ size arrry를 input으로 받고 모든 $f$ frames 마다 취해진 arrays를 출력함

→ 해당 operation은 downsampling factor $f$에 의해 feature arry의 시간(temporal) dimension을 줄임

- encoder은 $[2d, 96/f]$의 크기를 가진 feature array를 출력하고 결과적으로 $d$와 $f$가 bottleneck dimension을 통제함

- bottleneck의 크기를 통제함으로써 speaker identity 또는 phonetic 정보가 포함되지 않고 emotion 정보를 포함하는 disentangled speech representations를 얻고 싶어함

3.1.4 Decoder

- decoder에서는 temporal dimension의 각 feature를 $f$번 반복시킴으로써 encoder의 features가 upsampled 됨

- upsample시켰기 때문에 downsampling operation하기 전과 같은 크기가 됨

- encoder의 features가 오직 emotion information만 포함하고 있기 때문에

decoder은 encoder의 output뿐만 아니라 speaker identity embeddings와 phone sequence embeddings를 input으로 사용하여 spectrogram을 재구축할 수 있도록 함 - decoder의 linear layer로부터의 output은 각 speech frame에 대해 80의 크기를 가진 feature array임

- 해당 ouput은 speech segment의 mel-spectrogram을 나타냄

- 이 ouput features는

reconstruction loss$L_{r1}$의 평균들에 의해 원본 mel-spectrogram과 비교됨- $L_{r1}$은 모든 모델의 parameters를 update하는데 사용되는 놈임

- 또한 decoder의 말단 output과 위와 같은 원본 mel-spectrogram 사이를

reconstruction loss$L_{r2}$ 로 계산함

( 해당 식은 $L_{r1}$과 $L_{r2}$ 모두 적용되는 식 )

- $M$ : training batch size

- $x_k$ : model에 의해 출력된 batch안의 $k$번째 feature element

- $y_k$ : $x_k$에 대한 원본 정답 (ground-truth)

3.1.5 Phone Encoder (phone : 음)

- phone encoder은 phone embeddings의 sequence를 input으로 받음

- output은 전체 phone sequence에 대한 표현을 나타냄

- phone embedding을 얻기 위한 2-step

- (1) 각 utterance마다 Gentle aligner를 사용하여

speech signal과 해당 신호에 상응하는 text transcript로부터

phone alignment 정보를 추출함 - (2) 각 frame 마다 가장 긴 phone을 결정함으로써 phone alignment 정보로부터 phone sequence를 얻음

- (1) 각 utterance마다 Gentle aligner를 사용하여

- 각 phone에게 id 번호를 부여함

- not-identified된 phones인 silence와

dataset안의 각 special token에게도 ids를 할당함

(e.g. [LAUGHTER] : 웃음소리에 대한 token) - one-hot embedding방식으로 128개의 구분된 phone ids로 구성됨

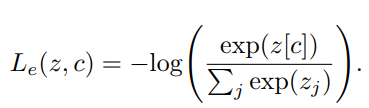

3.1.6 Classifier

- Classifier은 encoder의 output이 emotion의 정보를 포함할 수 있도록 유도함

emotion label$c$ 와 classifier에 의해 출력되는logits$z$의 softmax 사이를

cross-entropy loss $L_e$로 다음과 같이 계산함

3.1.7 Training and inference

- Training과정에서 최소화 되어질 목표 함수는 $L_{r1},L_{r2}$ 와 $L_e$ 사이의 합

- inference 과정에서는 emotion class 확률들을 얻기 위해서

softmax 함수가 model이 ouputted 한 emotion class logits array에 적용됨 - 가장 높은 확률 값을 가진 class가 final classification 결과로 선택됨

- 모델은 96frame의 speech segment로부터의 features를 input으로 받음

- utterance-level prediction을 얻기 위해서,

- 먼저 (overlap 없이) utterance에서 모든 96개의 연속적인 frames 마다 emotion class 확률들을 계산함 ( 필요에 따라 zero padding 함)

- 이러한 segment-level의 확률들의 평균을 최종 utterance-level의 확률로 정함

- ( 평균을 취했다고 하는것을 보면 segment각각을 classification 값 내고 이를 평균을 취한것 같음)

3.2 Text Emotion Recognition

- [35]는 TER 과제가 emotion classification을 수행하기 전 모든 text tokens의 embeddings를 수행하는것(processing)으로부터 이득을 얻을 수 있다는것을 보여줌

- 이러한 결과를 참고하여, Transformer-based models에서 추출된 an untterance안의 모든 token의 embeddings를 수행하는(process) CNN-based model을 제안함

- pre-trained Transformer-based models를 이용하여 각 utterance에 대해 shape가 $[U,L]$ 인 text representation을 추출함

- $N$ : special tokens을 제외한 utterance의 tokens의 수

- $L$ : 각 token의 feature의 size

- text representation을 zero-pad하였고 그 결과 TER model의 input은 $[N^{'}, L]$의 크기를 가짐

- $N^{'}$ : dataset의 an utterance에서 발견되는 최대 tokens 수

- 이 text features가 TER model에 processed 되고 cross-entropy loss로 학습이 됨

- inference하는 동안 SER model과 유사하게 emotion classification을 얻기위해서 softmax 함수는 TER model의 logits array에 적용됨

- 하지만 SER model과 달리, TER model의 ouput은 utterance-level emotion classification result를 나타냄

3.3 Multimodal Emotion Recognition

- 같은 utterance에 대한 speech-based utterance-level 확률들 $p_s$와 text model로 부터 출력되는 확률들 $p_t$는 다음과 같이 결합됨

- $p_f$ : fused probability

- $w_1$ : speech modalities에 할당된 fixed weights

- $w_2$ : text modalities에 할당된 fixed weights

- weigths들은 fused probability에 대해서 각 data modality의 기여 정도를 결정함

- an utterance에 대한 emotion classification의 결과는 가장 높은 fused probability를 가진 emotion class에 상응함

4. Dataset

- IEMOCAP dataset 사용

- dataset에 10명의 배우들이 있음

- 그들의 대화들은 5 dyadic sessions로 구성되어 있음

- 각 dyadic은 남자와 여자 배우들의 서로다른 짝으로 구성

- dataset에 10명의 배우들이 있음

- dataset은 대략 12시간의 audiovisual data며, 이들은 speech(혹은 utterances)로 segmented 됨

- 각 utterance는 3명의 주석자에 의해 labelled 됨

- 최소 두명의 주석자가 같은 label을 취한 utterances에 대해서만 이용을 함

- “Happy” 와 “Excited” category의 utterances를 “Happy”로 통일하여 labelling 함

- “Angry”, “Neutral”, “sad” 그리고 “Happy”에 대한 labels를 가진 utterances만을 선택했고 결과적으로 대략 7시간의 데이터인 5531 utterances

- 오직 speech data, transcripts 그리고 labels만 사용함

5. Training Configuration

leave-one-sesion-out cross-validation을 모든 experiments에서 수행함- WA와 UA의 관점에서 결과들을 보고함

- WA : 모든 emotion class를 반영한 average recall

- UA : 올바르게 분류한 sample의 비율

- 모든 models는 Pytorch로 만듬

- 모든 training experiment마다

- Adam optimizer

- with learning rate : $10^{-4}$

- with the default exponential decay rate of the moment estimates

- (순간 변화의 기본적 지수적 감소 : 미분 순간 변화율로 decay rate 사용한듯)

- SER models는

- batch size : 2

- iteration : 1 million

- TER models는

- batch size : 4

- iteration : 412,800

6. SPeech Emotion Recognition

6.1 Emotion Recognition Experiments

- encoder에 두 개의 bottleneck configurations를 수행하고 각각 down-sampling factor을 다르게 함

- “Small”

- $d$ : 8

- $f$ : 48

- “Large”

- $d$ : 128

- $f$ : 2

- “Small”

- utterance-level SER 결과는 Table 1과 같음

- SER task에 대해서 “Large” model과 비교했을 때 “Small” 배치가 더 좋은 성능을 보임

- Table2는 “Small” model에서 얻어진 결과들을 최신 state-of-the-art와 비교

- 추가로 wav2vec embeddings를 입력으로 넣는것이 SER에게 좋은 성능에 도움이 되는지(advantageous)에 대한 평가를 함

- “Small” 형태와 같은 parameters로 학습을 하는데 input을 wav2vec features가 아닌 a mel-spectrogram을 대신 사용했음

- 그 결과 absolute accuracy 관점에서 5-fold cross-validation에 대한 UA가 50.4%로

input을 wav2vec embeddings로 했을 때 보다 19.7%더 안좋게 나옴

→ 그러므로 전통적인 mel-frequency spectrograms와 비교할 때, wav2vec embeddings의 learned weighted 평균이 IEMOCAP dataset을 사용한 SER에 대해서 더 나은 representation을 보여준다는 결론을 내릴 수 있음

6.2 Disentanglement Experiments

- speaker identification task를 해결하기 위해서 얻어진 speech representations에 4-linear layer classifiers를 학습시킴

- 4-linear layer classifiers

- input에서 ouput방향으로 2048, 1024, 1024, 8 nuerons를 가짐

- 4-linear layer classifiers

- 저자들의 목표는 얻어진 emotion features가 speaker identity 정보를 가지고 있는지 아닌지에 대해서 보는것임

- 이상적으로 저자들이 원하는 것은 features가

speaker-independent하고, 어떤 speakers이든간에 사용될 수 있는 포괄적인 emotion representation을 담고 있는것임 - 5-fold cross-validation 방식으로 classifiers를 학습시켰고 이번 experiment에서는 folds를 다르게 정의함

- 랜덤하게 분리시켜서, 각 speaker의 data의 80%는 training과정에 사용하고 나머지 20%는 test과정에 사용

- 해당 folds들은 speaker dependent한 train과 test sets를 가지고 있고,

그들의 각각은 오직 4 sessions의 data를 포함하고 있음

- classifiers를 cross-entropy loss로 학습시킴

- Table3는 speaker identity recognition results를 요약함

- Table3이 suggests하는 것은 “Large” model로 추출된 features는 “Small” model로 추출된 것 보다 speaker identity에 대한 정보가 더 많이 포함하고 있다는 것임

- Table3과 Table1의 결과를 전체적으로 볼 때, “Large” model과 비교했을 때, “Small” model로 부터 추출된 features가 더 나은 SER accuracy를 가지고 worse한 speaker identity accuracy를 보여줌

→ 이러한 결과는 bottleneck size가 speech에서 disentanglement의 factors로 결정될 수 있다고 말함 (which makes the SER task easier)

6.3 Discussion

- 저자들은 그들의 SER model이 3가지 요소들 때문에 이전의 방식들과 비교했을 때 더 나은 결과를 얻을 수 있다고 말함.

- 1) 자신들의 model에 high-level speech representations를 input으로 사용했다는 점

- 2) section 6.2에서 보여졌듯이 features가 certain level of disentanglement를 가지고도록 만드는 모델에 의해 얻어진 features에서 encoded된 정보를 분석하는데 사려깊게 했다는 점

- 3) wav2vec features로부터 spectrograms를 재구성되도록 학습시켰기 때문에 high-level과 low-level features 둘 다 활용할 수 있다는 점

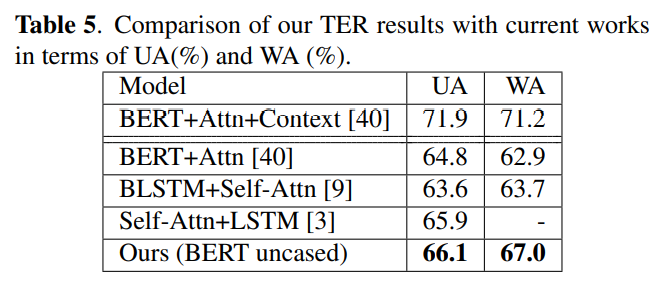

7. Text Emotion Recognition

- 서로 다른 Transformer-based models로부터 추출된 input features를 이용하여 TER model을 학습시킴

- Transformer-based-models 모두 “large” version으로 사용했고 이들은 각 token에 대해서 1024-dimensional feature을 출력함

- TER 결과는 Table4에서 서로 다른 feature extractors에 대해서 보여짐

- Table5에서 제일 잘 나온 결과를 최신 state-of-art와 비교함

- context information을 사용한 [40]을 제외하고 논문의 방식이 이전의 연구들보다 더 나은 결과를 초래했다는 것을 볼 수 있음

- context information(i.e., features from succeeding and preceding utterances)

- 논문의 모델이 이전 연구들과 다른 점은 recurrent nueral networks 혹은 self-attention을 사용하지 않았다는점과

large text corpora에서 학습된 Transformer-based models에 의해 학습된 text representations로 부터 이득을 봤다는 점임 - 저자들은 BERT의 deep features와

token의 features의 sequence로 부터 temporal 정보를 추출하는 (논문에서 만든) 1D CNN layers의 능력이 좋은 결과를 초래하는 원인이라고 믿음

8. Multimodal Emotion Recognition

- 서로 다른 weight 값들 $w_1$과 $w_2$로 실험함으로써 best speech와 best text model로 부터 나온 결과를 결합했음

- 제일 좋았던 값

- $w_1$ : 0.6

- $w_2$ : 1

- 제일 좋았던 값

- 이 결과가 보여주는점은 speech model의 정확도가 text model의 정확도보다 높더라도, speech와 text 결과를 combining할 때 speech model의 결과에 더 적은 중요도를 주는것이 낫다는 것을 보여줌

- 연구진들은 이 현상d이 TER과 SER models가 얻는 confidence score과 관련되어 있다고 믿음. 하지만 더 조사가 필요함

- Table1, 4, 6의 결과를 비교함으로써, emotion recognition task의 해결책은 서로 다른 data의 type들을 조합하는것으로 부터 이득을 얻을 수 있다는 결론을 내릴 수 있음

- 이들의 multimodal 결과가 speech-only 그리고 text-only 결과보다 더 좋게 나왔기 때문임

- 연구진들은 그들의 좋은 결과가 나온 이유가 그들의 fusion 방식을 사용하지 않더라도 그들의 단일모델들이 다른 단일 모델들보다 더 좋은 성능을 보였다는 사실 덕분이라고 생각함

- 그들은 더 정교화된 fusion 방식 혹은 speech와 text modalities를 더 연결성있게 학습시킴으로써 더 나은 결과를 낼 수 있다고 믿음

9. Concolusion

- 논문의 모델은 high-level wav2vec features와 low-level mel-frequency spectrograms를 둘 다 활용할 수 있고 IEMOCAP dataset에 대해 70.1%의 정확도를 달성함

- TER에 대해서도 66.1% 정확도를 성취함

- fusion 결과에 대해서73.0% 정확도를 달성함

- emotion recognition이 disentanglement representation learning, high level data representations 그리고 multimodalities로 부터 이득을 볼 수 있다는것을 보여주면서 최신 연구들을 뛰어넘은 결과를 보여줌

'It공부 > 딥러닝논문리뷰' 카테고리의 다른 글

Comments